Az MI-vel kapcsolatos vélt vagy valós félelmeknek széles tárháza van. Egyesek úgy gondolják, hogy robotizáció miatt nem lesz szükség az emberek munkájára, mások meglátásában az emberi gondolkodás és a kreativitás fog csökkenni és vannak, akik az emberiség teljes pusztulását vizionálják az önállóan gondolkodó gépek miatt. A mesterséges intelligencia viszont továbbra is gyerekcipőben jár és még mindig inkább egy eszköz a felhasználó számára, mintsem egy saját tudattal bíró entitás. Használata éppúgy megkönnyítheti egyesek számára a mindennapokat, mint ahogyan megkeserítheti mások számára azokat. Mivel a szorongások középpontjában a gépek uralmától való félelem áll, sokkal kevesebb figyelmet kapnak azok az esetek, amikor valódi felhasználók követnek el bűncselekményeket az AI segítségével.

Szexuális zsarolás

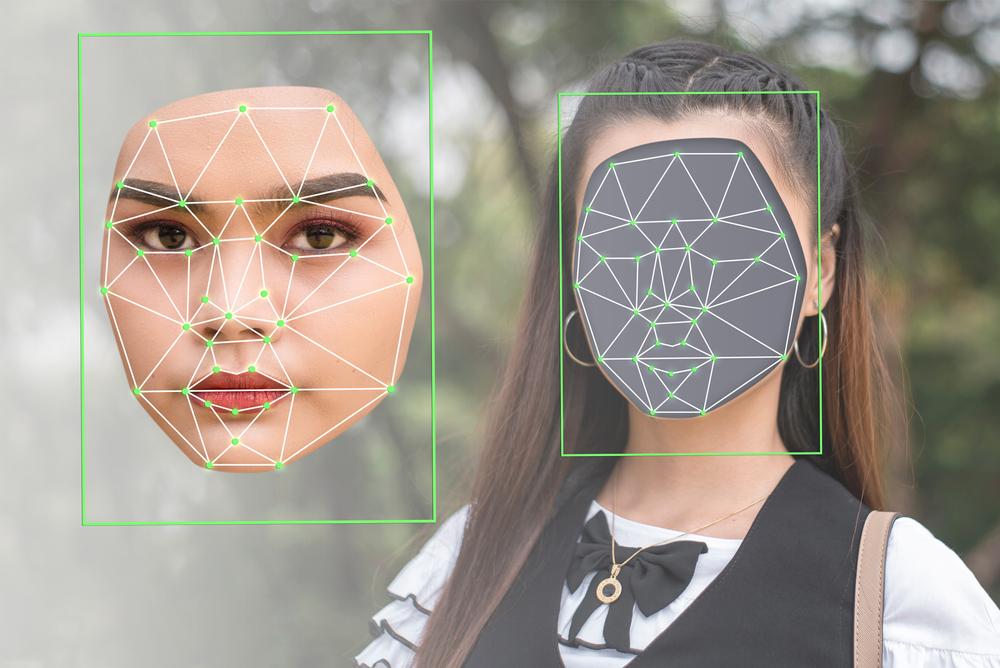

A mesterséges intelligencia által generált deepfake a generatív intelligencia robbanásszerű fejlődése előtt is népszerű volt. Humoros és lejárató videók, politikusi beszédek, valamint pornográf tartalmak előállítására használták leginkább és a középpontban ismert emberek álltak. Ezek kisebb részben okoztak károkat a felhasznált alanynak, hiszen könnyen cáfolható anyagok voltak és nagyobb részben a vágyott igényt elégítették ki a tömegek részéről legyen az akár egy rossz nyilatkozat valamelyik közszereplőtől vagy egy celebritás meztelen képei. A csalók azonban rájöttek, hogy az új alkotóeszközök segítségével könnyebb profitálni a hétköznapi emberek kárán, ezért őket kezdték el célozni. A deepfake videók terjesztésére vonatkozó jogi szabályozás igen változó, így például a technológiailag magasan fejlett Dél-Korea már 2019-ben létrehozott egy Nemzeti Mesterséges Intelligencia Stratégiát és 2020-ban törvénybe foglalta, hogy tilos olyan deepfakek terjesztése, amelyek közérdeket sérthetnek. A digitális műveltségben lemaradó térségekben – mint Latin-Amerika, Dél-Afrika és Közép-Ázsia, de az EU-ban is csak közvetett szabályozás létezik – emellett nem bűntetendő a realisztikus deepfake videók kreálása és terjesztése. Az online pornográfia témái a nők, ezért az ilyen tartalmakat hasonlóan a bosszúpornóhoz a nemi alapon elkövetett bűncselekmények közé lehetne sorolni. Bár a közösségi média felületeken tiltólistán vannak az ilyen erotikus oldalakra irányító linkek, sok esetben vírus formájában egyszerűen terjednek és aki rákattintott egyszer, automatikusan osztja tovább akár üzenetben, akár a hírfolyamban ezeket. A generatív intelligencia fejlődésével a zsarolási potenciál is egyre nagyobb, hiszen egyre tökéletesebb képeket és videókat tudnak létrehozni. Ez lett a szexuális zsarolás új gyakorlata, amelynek a „sextortion” kifejezést adták a hatóságok. A dark weben a deepfake pornót gyártó applikációk népszerűbbek, mint valaha: akár havi 10 dolláros összegért is jó minőségű profilképek százezreihez férhetnek hozzá azok, akik regisztrálnak. Ezek az alkalmazások közösségi médiában nyilvánosan hozzáférhető képeinkből, valamint a szexipar meztelen képeit alkalmazva hoznak létre a felhasználó által kívánt tartalmat. Ezt követően vagy saját maguknak elmentik, vagy továbbítják azt az áldozatnak, egyre nagyobb összegeket követelve tőle, annak érdekében, hogy ne hozzák nyilvánosságra a hamisan létrehozott tartalmakat. Más esetben viszont pont, hogy azt akarják elérni, hogy valóban a kiszemelt személy küldjön saját magáról meztelen képeket. A szerverek, ahol ezeket a felvételeket tárolják nehezen elérhetőek, azonosíthatóak, gyakran más országokban vannak. Így hiába is tennének feljelentést az áldozatok, a hatóságok nem tudnak mit tenni. A kameratechnológiák fejlődésével, az arcképes azonosítással, valamint a tömeges megfigyelőrendszereken keresztül a hackerek bárki arcképéhez hozzáférhetnek, még akkor is, ha nem töltöttünk fel magunkról képet valamelyik közösségi felületre.

A szeretteinket használják fel

A csalóknál jól bevált módszerré vált, hogy az áldozat családtagjának kiadva magukat, valamilyen vészhelyzetre hivatkozva kérnek pénzt. Magyarországon ez a csalási forma az unokázás néven fut és céltáblái az idős emberek. A mesterséges intelligenciával működő hangtorzító eszközök segítségével azonban egy hangminta alapján bárkinek a hangját képesek utánozni a csalók. Ehhez elég bármilyen hangrészlet, akár egy videóból, podcastből. Más szoftverek segítségével pedig nyelv, dialektus, kor, nem alapján kereshetünk egyéni hangsémákra és egy nagyon hasonló hang lesz a végeredmény. Erre szakosodott az ElevenLab szoftver is, amely az ingyenes szinttől a prémium 330 dollár/hó tagságig minden igényt kielégít ezen a téren. Az igazán dörzsölt szélhámosok felhívják a kiszemelt áldozatot, aki lehetőleg idős vagy olyan, akinek beteg rokona van, majd eljátsszák a hívás során, hogy átadják a készüléket a rokonnak. Majd azt kérik, hogy utaljanak át pénzt egy megadott számlaszámra, de a levélben feladott készpénz a legjobb, mert azt nem lehet lekövetni. Akik pedig nem egy rokonnak adják ki magukat, azok egy elhunyt családtag történetét használják fel hogy hitelesebbnek tűnjenek. A legújabb TikTok trendben például a mesterséges intelligencia segítségével generálják újra a gyerekgyilkosságok áldozatait. A brutális cselekedetek újbóli megalkotása a „true crime” vagyis a bűncselekményeket valósághűen, hitelesen bemutató dokumentumfilmekhez köthető, amelyek népszerűsége töretlen a kábel televíziózás óta és a különböző streamingszolgáltatók is sikeresen felvették a kínálatukba ezeket a sorozatokat. A TikTok true crime videókban egy generatív intelligencia által létrehozott gyerek meséli el élettörténetét és halálának körülményeit. Ezeket valós történetek inspirálják, amelyekkel az alkotók fel szeretnék hívni a tömegek figyelmét az áldozatok történetére. Ebben a formában ugyan nem tekinthető kegyeletsértésnek, amit csinálnak, de nagyon közel járnak hozzá. Inkább jogi magyarázata lehet annak, hogy alternatív sztorival állnak elő, hiszen a kínai közösségi média irányelvei szerint tilos valós személyről deepfake tartalmat feltölteni a felületre. Mivel true crime rajongók mélyen beleássák magukat a további eseményekbe, így gyakran felkeresik az elhunytak hozzátartozóit, de ők maguk is találkozhatnak a több százezres megtekintéseket produkáló videókkal. Az etikai kérdések tehát adottak, hiszen miért akarná valaki újra traumatizálni a hozzátartozókat, hacsak nem megtekintések miatt?

Önmagunk becsapása

A kiberbiztonsági szakértők jelenleg azon az állásponton vannak, hogy a mesterséges intelligencia, a virtuális valóság, a deepfake, valamint a számítógépes grafikák fejlődése pár éven belül elérheti azt a szintet, amikor már nem tudjuk megkülönböztetni azokat a valóságtól.

A probléma a jogi szabályozás hiányossága mellett az, hogy a felhasználók önszántukból lépnek rá a digitális önbecsapás útjára. A különböző arcfilterek, arcszerkesztők segítségével egy „tökéletes” – a valóságban azonban egy számítógép által torzított – képet lehet létrehozni. Tulajdonképpen egy virtuális plasztikai sebészt vesznek így igénybe és mossák el a határokat az offline valóság hibái és az online világ tökéletes képei között. A felnövő generációk, akik teljes mértékben a világhálón és a közösségi médiaplatformokon szocializálódnak, képtelenek lesznek megkülönböztetni a hamisított deepfake tartalmakat a valós felvételektől. Amíg nincsen átfogó reguláció addig az egyéneknek kell felvenniük a harcot a csaló tartalmakkal szemben. Érdemes használni a deepfake felismerésére, kiszűrésére használt alkalmazásokat, mint a Deeptrace vagy a Truepic. Érdemes korlátozni a közösségi médiában megjelent képeink számát is, illetve, hogy ki láthatja ezeket. Ezen felül rendszeresen futtassunk le kereséseket saját magunkról, családtagjainkról és próbáljunk eltávolíttatni a rólunk készült, harmadik félnél lévő, nyilvánosan hozzáférhető képeket.

Szitás Péter

Forrásjegyzék

Ej Dickson: Deepfakes of True-Crime Victims Are a Waking Nightmare. Rolling Stone. 2023.05.30.

Jeff Burt: Deepfakes being used in ‘sextortion’ scams, FBI warns. The Register.2023.06.08.

Noor Mahtani: Is digital violence in an AI era yet another threat to women? El Pais. 2022.05.22.

Válogatás korábbi hasonló írásainkból

Hogyan lehet felismerni a mesterséges intelligencia által készített képeket?

Információs társdalom 4: Létezik-e internetes kultúra?

Kommunikációs forradalom 5: mi következik az igazság után?

Öt javaslat az internet és a mesterséges intelligencia szabályozására